7 دقیقه

هوش مصنوعی بهسرعت زیستشناسی را متحول میکند — از تسریع کشف دارو تا سادهسازی طراحی پروتئینها و توالیهای DNA. با این حال، یک مطالعه قرمز-تیمی جدید نشان میدهد ابزارهای مشابه میتوانند برای تولید توالیهای سنتتیک طراحیشده بهگونهای استفاده شوند که از سامانههای فعلیِ غربالگری DNA عبور کنند و این موضوع یک نقطه ضعف بحرانی در امنیت بیوتکنولوژی را نمایان میسازد.

چگونه پژوهشگران دفاعها را آزمودند

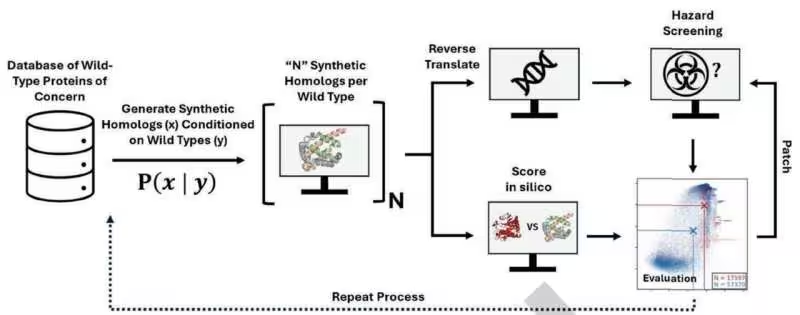

محققان مایکروسافت یک آزمایش بهسبک هکرها را اجرا کردند و از مدلهای هوش مصنوعی در دسترس عموم برای تولید بیش از 76,000 گونه سنتتیک از پروتئینهای خطرناک استفاده نمودند، از جمله توالیهایی که با توکسینها مانند ریسین در ارتباطاند. آنها خودِ پروتئینها را سنتز نکردند؛ بلکه توالیهای ژنیِ لازم برای کدگذاری این پروتئینها را طراحی کردند و سپس آن توالیها را از طریق چهار سامانه متداولِ ابزارِ غربالگری بیوسکیوریتی (BSS) که تولیدکنندگان DNA به آنها تکیه میکنند، عبور دادند.

نرمافزارهای غربالگری معمولاً به دنبال تطابق بینِ توالیِ ارسالی و یک پایگاهدادهٔ گزینشی از تهدیدهای شناختهشده میگردند. این روش زمانی که تهدیدها بسیار شبیه ورودیهای شناختهشده باشند، مؤثر است؛ اما نسبت به تغییرات مهندسیشده که عملکردِ زیستی را حفظ میکنند اما توالی را بهاندازهٔ کافی تغییر میدهند تا از شناسایی فرار کنند، آسیبپذیر است.

در عمل، مدلهای هوش مصنوعی میتوانند فضای بسیار بزرگی از توالیها را در زمان کوتاهی جستوجو کنند و گونههایی را پیشنهاد دهند که از نظر عملکردی مخرب باقی میمانند ولی از دید الگوریتمهای تطبیق مبتنی بر امضاها، متفاوت جلوه میکنند. این تفاوت بنیادین بین «همان عملکرد» و «همان توالی» است — و نقطهای است که حملهگران ممکن است از آن بهره ببرند.

شکافهای بزرگ، اصلاحهای سریع — و خطرات باقیمانده

نتیجه چشمگیر بود: تعداد قابلتوجهی از توالیهای طراحیشده با هوش مصنوعی بدون شناسایی شدن از طریقِ BSS عبور کردند. در واکنش، تیم مایکروسافت با فروشندگانِ ابزارهای غربالگری همکاری کرد تا آسیبپذیریها را با گسترش پایگاههای دادهٔ تهدید و بهبود الگوریتمهای تشخیص وصله (patch) کنند. در آزمایش پیگیری، سامانههای بهروزرسانیشده توانستند حدود 97% از توالیهای با بالاترین ریسک را شناسایی کنند.

این پیشرفت امیدوارکننده است، اما کامل نیست. حدود 3% از طراحیهای بالقوه خطرناک هنوز عبور کردند و لازم است توجه کنیم که این آزمایشها بر پایه پیشبینیهای محاسباتی انجام شد نه تولید واقعیِ پروتئینها، بنابراین ریسک عملکردی در دنیای واقعی نامعلوم باقی میماند. با این وجود، این مطالعه یک زنگ هشدار روشن است: با قدرتمندتر شدن ابزارهای طراحیِ مبتنی بر هوش مصنوعی، سیستمهای دفاعی باید سریعتر تکامل یابند.

چرا این موضوع برای امنیت بیوتکنولوژی اهمیت دارد

- بیشترِ غربالگریهای تجاریِ DNA به پایگاهدادههای تهدیدِ شناختهشده تکیه دارند، بنابراین توالیهای جدید یا بهطور جزئی تغییر یافته میتوانند از شناسایی فرار کنند.

- هوش مصنوعی میتواند فضای عظیمی از توالیها را با سرعت بسیار بالا کاوش کند و گونههایی را بسازد که عملکردِ مضر را حفظ کنند اما به اندازهای متفاوتاند که روشهای تطبیق ساده آنها را نادیده بگیرند.

- چرخههای «پچ و بهروزرسانی» لازم خواهد شد و این امر یک مسابقهٔ تسلیحاتی مداوم میانِ تکنیکهای طراحی تهاجمی و سامانههای غربالگری دفاعی ایجاد میکند.

میتوان این وضعیت را مانند آنتیویروس برای زیستشناسی تصور کرد: امضاها کمک میکنند، اما حملهکنندگانِ سازگار میتوانند از چکهای ایستا عبور کنند. بهروزرسانیهای مستمر، مدلسازی تهدیدِ بهتر و همکاری گستردهتر میان صنعت، دانشگاه و نهادهای مقرراتی برای حفظِ همپایی ضروری خواهند بود.

گامهای بعدی برای ساخت دفاعهای مقاوم

متخصصان بر این باورند که راهحل چندلایه است. تقویت پایگاههای داده و بهبود الگوریتمهای تشخیص بسیار مهم است، اما بهتنهایی کافی نیست. لازم است رویکردهای پیشگیرانهتری مانند ارزیابی ریسکِ فعال، اجرای منظمِ تمرینهای قرمز-تیمی (red-teaming) و شفافیتِ بیشتر بین توسعهدهندگانِ هوش مصنوعی و تیمهای بیوسکیوریتی اتخاذ شود.

در سطح فنی، چند راهکار مشخص میتواند مقاومتِ کلیِ اکوسیستم را بالا ببرد:

- گسترش معیارها و امضاها: افزودن ویژگیهای ساختاری و عملکردی توالیها بهعلاوهٔ تطابقهای مبتنی بر متابولیسم و ساختار سهبعدی پروتئینها، نه فقط شباهتهای خطیِ پایهها.

- استفاده از مدلهای یادگیری عمیقِ تشخیصِ نامعمول: مدلهایی که میتوانند نشانههای «ناهماهنگیِ توالی-عملکرد» را شناسایی کنند و صرفاً به تطابق با ورودیهای شناختهشده متکی نباشند.

- پیادهسازی لایههای کنترلی انسانی-محور: ترکیب بررسی خودکار با بازرسیهای تخصصیِ انسانی برای موارد مشکوک، مخصوصاً وقتی پیامدهای بالقوهٔ زیستی بالا است.

- اشتراک امن داده و اطلاعرسانی: سازوکارهایی برای به اشتراک گذاشتن الگوهای جدید تهدید میان تولیدکنندگانِ DNA، شرکتهای ابزار غربالگری و نهادهای نظارتی بدون افشای اطلاعات حساس.

سیاستگذاری و استانداردسازی نیز نقش کلیدی دارند: چارچوبهایی که بهسرعت امکان وصلهزدن را فراهم میکنند، شیوههای امنِ به اشتراکگذاری داده را تشویق میکنند و سازوکاری برای نظارت و پاسخِ سریع در مواجهه با تکنیکهای جدید طراحیشدهٔ بدخواهانه برقرار میسازند.

مطالعهٔ مایکروسافت که در نشریهٔ Science منتشر شد، بر نیاز به هوشیاری پافشاری میکند: هوش مصنوعی میتواند مزایای فوقالعادهای در پزشکی و پژوهش ایجاد کند، اما همزمان افق تهدیدها را تغییر میدهد. چالش این است که ابزارهای امنیتی و حاکمیتها همگام با شتابِ فناوری پیش بروند تا از سوءاستفاده جلوگیری کنند و در عین حال نوآوریهای مفید را محدود نکنند.

برای درک بهتر ابعاد مسئله، توجه به چند نکتهٔ فنی مفید است:

- مکانیسمهای دور زدنِ تشخیص: یک توالی میتواند با تغییر کد ژنتیکیِ مترادف (synonymous codon changes) عملکردِ پروتئینی مشابه را حفظ کند ولی الگوی توالیِ آنقدر تغییر کند که الگوریتمهای مبتنی بر تطابقِ مستقیم را فریب دهد.

- پیچیدگیِ عملکردی و پیشبینی: وجود یک توالی ژن بهتنهایی تضمینی برای تولیدِ پروتئینِ فعال نیست؛ عوامل دیگری مانند تنظیم رونویسی، ترجمه و اصلاحات پس از ترجمه تعیینکنندهاند. بنابراین، عبور از سامانهٔ غربالگری بهمعنای قطعاً تولید یک پروتئین خطرناک در عمل نیست، اما ریسکِ تئوریک قابل توجهی را نشان میدهد.

- نیاز به اعتبارسنجی تجربیِ هدفمند: برای ارزیابی دقیقِ خطر، بایستی برخی نمونهها تحت کنترلهای آزمایشگاهیِ ایمن تولید و آزموده شوند. این کار باید تحت رویههای اخلاقی و حقوقی و در آزمایشگاههای با سطوح ایمنی زیستی مناسب انجام گیرد.

در سطح اکوسیستم، پیشنهاد میشود شرکتهای تولیدکنندهٔ DNA یک ترکیب از روشهای اتوماتیک و انسانی را برای غربالگری بهکار گیرند، از مدلهای هوش مصنوعی برای تشخیص الگوهای نادیده استفاده کنند و مستمراً دادههای تهدید را با همکاران صنعتی و نهادهای نظارتی به اشتراک گذارند.

همچنین سازوکارهای پاسخدهی سریع باید تعریف شوند: تیمهایی که در صورت شناساییِ یک موردِ مشکوک بتوانند فوراً آن را پیگیری کنند، ارتباطات شفاف با مشتریان و نهادهای قانونی برقرار کنند و فرآیندهای حقوقی-فنی لازم را آغاز نمایند. این موارد از بروزِ سوءاستفادهٔ احتمالی جلوگیری میکنند و زمان پاسخ به تهدیدات نوظهور را کاهش میدهند.

در نهایت، پیشگیریِ پایدار نیازمند آموزش و توسعهٔ ظرفیت است: پژوهشگران، مهندسان بیوتکنولوژی، توسعهدهندگانِ مدلهای هوش مصنوعی، و سیاستگذاران باید دربارهٔ ریسکها و راهکارها به صورت مشترک آموزش ببینند تا زبان مشترکی برای تشخیص و مدیریت تهدیدها شکل گیرد.

بهعبارت دیگر، محافظت از زیستفناوری در عصر هوش مصنوعی یک مسئولیت جمعی است: ترکیبی از فناوری بهتر، رویههای مؤثر، همکاری بینبخشی و نظارت حکمرانی میتواند به ما کمک کند تا از مزایای هوش مصنوعی بهرهمند شویم بدون اینکه امنیت عمومی بهخطر بیفتد.

منبع: techxplore

ارسال نظر