9 دقیقه

یافتهای غافلگیرکننده از یک مطالعه مشترک بین دانشگاه مریلند و مایکروسافت: زبان لهستانی در مقایسه با ۲۵ زبان دیگر بهترین کارایی را برای پرامپتدهی به مدلهای زبان بزرگ نشان داد، در حالی که زبان انگلیسی تنها در ردهٔ ششم قرار گرفت.

چگونه پژوهشگران عملکرد زبانها را با هوش مصنوعی آزمایش کردند

تیم تحقیقاتی مجموعهای از پرامپتهای یکسان را به ۲۶ زبان ترجمه کرده و آنها را به چندین مدل زبانی بزرگ تغذیه کردند — از جمله مدلهای OpenAI، Google Gemini، Qwen، Llama و DeepSeek — و سپس دقت انجام وظایف را اندازهگیری کردند. برخلاف انتظار، زبان لهستانی با میانگین دقت وظایف برابر با ۸۸٪ در صدر قرار گرفت.

روششناسی آزمایش

در این پژوهش، گروه تحقیق از مجموعهای از پرسشها و دستورالعملهای استاندارد برای سنجش توانایی مدلها در انجام وظایف مختلف استفاده کرد. پرسشها شامل دستورالعملهای دستهبندی، خلاصهسازی متن، پاسخدهی به پرسشهای چندگزینهای و تولید متن طولانی بود. هر پرامپت ابتدا به انگلیسی طراحی و سپس با روشهای ترجمه انسانی و ماشینی به ۲۶ زبان منتقل شد تا معادلهای معنایی حفظ شوند.

برای سنجش عملکرد، محققان معیارهای چندگانهای را لحاظ کردند: دقت (accuracy) برای وظایف طبقهبندی، کیفیت محتوا و تطابق معنایی برای تولید متن، و مقایسهٔ خروجیها با پاسخهای مرجع انسانی. همچنین سازوکارهایی برای کاهش سوگیری ناشی از ترجمه اعمال شد تا نقش زبانِ پرامپت در نمایش واقعی مدل مشخصتر شود. این رویکرد نشان میدهد که آزمونهای چندزبانه و معیارهای دقیق برای ارزیابی مدلهای زبانی بزرگ ضروریاند.

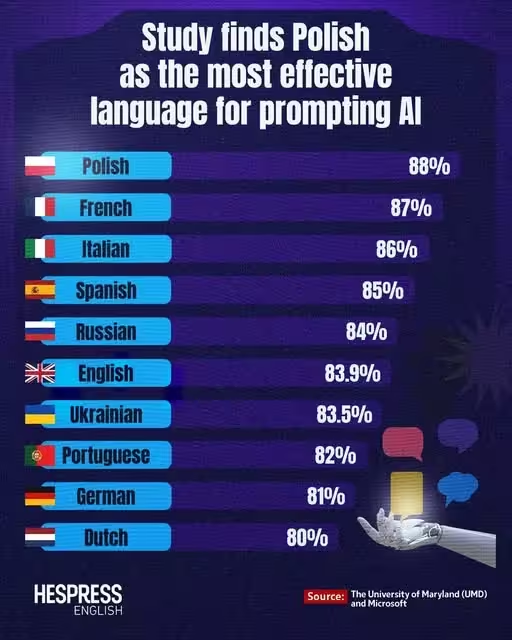

برترین زبانها برای پرامپتدهی به هوش مصنوعی — جدول رتبهبندی مطالعه

در اینجا ده زبان با بهترین عملکرد در مطالعه، بر اساس میانگین دقت در انجام وظایف آورده شدهاند:

- زبان لهستانی — ۸۸٪

- زبان فرانسوی — ۸۷٪

- زبان ایتالیایی — ۸۶٪

- زبان اسپانیایی — ۸۵٪

- زبان روسی — ۸۴٪

- زبان انگلیسی — ۸۳.۹٪

- زبان اوکراینی — ۸۳.۵٪

- زبان پرتغالی — ۸۲٪

- زبان آلمانی — ۸۱٪

- زبان هلندی — ۸۰٪

چرا ممکن است لهستانی برای پرامپت بهتر باشد؟

چند نظریه میتواند این نتیجهٔ غیرمنتظره را توضیح دهد. زبان لهستانی از نظر صرف و نحو بسیار غنی است و قاعدههای املا نسبتاً ثابتی دارد که ممکن است منجر به تولید توکنهایی شود که با طرحهای توکنسازی مدلهای ترنسفورمر همترازی بهتری دارند. این ویژگی میتواند پرامپتها را برای مدلها واضحتر کند، حتی اگر نمونههای آموزشی لهستانی نسبت به زبانهای پرکاربرد کمتر باشد.

نقش توکنسازی و زیرواحدهای زبانی

توکنسازی (tokenization) یکی از عوامل کلیدی است. مدلهای زبانی بزرگ اغلب از تکنیکهایی مانند BPE (Byte-Pair Encoding)، WordPiece یا unigram استفاده میکنند که در آنها کلمات به زیربخشهایی تقسیم میشوند. در زبانهایی که ساختار صرفی مشخص و الگوهای تکرارشونده دارند، توکنسازی ممکن است زیرواحدهای معنادارتری تولید کند که به مدل کمک میکند الگوهای دستوری و معنایی را بهتر یاد بگیرد. لهستانی با وجود وارونگیهای صرفی و بندهای واژگانی منظم، ممکن است در این زمینه مزیت داشته باشد.

از سوی دیگر، زبانهایی مانند چینی، که از نوشتار مبتنی بر کاراکتر استفاده میکنند، نیازمند استراتژیهای متفاوت توکنسازی و پیشپردازش (preprocessing) هستند. این تفاوتها نشان میدهد که فقط حجم دادهٔ آموزشی بزرگ تضمینکنندهٔ عملکرد بهتر در همهٔ زبانها نیست؛ بلکه چگونگی نمایش زبان در سطح توکن نیز اهمیت دارد.

ابهام، عبارات و سیگنالهای دستوری

عامل دیگر مربوط به میزان ابهام و ساختار عبارات است: برخی زبانها بهطور طبیعی الزامات دستوری یا سیگنالهای معناشناختی واضحتری دارند که احتمالا احتمال تفسیر نادرست نیت کاربر را کاهش میدهد. به عبارت دیگر، زبانهایی که در آنها جایگاه واژگان، نقشهای نحوی و نشانگرهای دستوری شفافتر است، میتوانند راهنماییهای صریحتری به مدل بدهند.

مطالعه نشان میدهد که «سختی یادگیری زبان برای انسان» لزوماً با «سختی پردازش آن برای مدل» همراستا نیست؛ مدلها میتوانند الگوهای ساختاری را حتی در زبانهایی که یادگیری آنها برای انسان مشکل است، به دقت ثبت کنند.

بهعلاوه، توزیع و تنوع دادههای آموزشی نیز مهم است: اگرچه برخی زبانها مجموعهدادهٔ بزرگتری دارند، اما کیفیت، تنوع سبکها (محاورهای، فنی، خبری) و نمایندگی دستوری میتواند تفاوتهای قابل توجهی ایجاد کند.

در مقابل، زبان چینی در این ارزیابی در میانهٔ پایین جدول قرار گرفت (چهارم از آخر)، که نشان میدهد در دست داشتن دادههای فراوان بهتنهایی ضمانت عملکرد برتر در همهٔ زبانها نیست.

پیامدها برای مهندسی پرامپت و هوش مصنوعی چندزبانه

پس توسعهدهندگان، پژوهشگران و مهندسان پرامپت چه نتایجی باید بگیرند؟

- انگلیسی را همیشه بهترین فرض نکنید: پرامپتها را در چند زبان آزمایش کنید — ممکن است در زبانی غیرباورکردنی خروجیهای دقیقتر یا مختصرتری بهدست آورید.

- اثر صرف و توکنسازی را در طراحی بنچمارکهای چندزبانه یا مجموعهدادههای فاینتیونینگ در نظر بگیرید: آگاهی از ویژگیهای زبانشناختی میتواند به انتخاب بهتری از روشهای توکنسازی و پیشپردازش منجر شود.

- برای پیادهسازیهای بینالمللی، رفتار مدل را در زبانهای مقصد ارزیابی کنید و از تعمیم نادرست از آزمایشهای صرفاً انگلیسی پرهیز کنید.

توصیههای عملی برای مهندسان پرامپت

در سطح عملیاتی، مهندسان پرامپت میتوانند گامهای زیر را مد نظر قرار دهند:

- پرامپتهای معادل را در چند زبان طراحی و مقایسه کنید تا زبان یا سبک زبانی که بهترین پاسخ را تولید میکند شناسایی شود.

- نرخ توکنسازی و توزیع طول توکنها را زیر نظر بگیرید؛ در برخی موارد سادهسازی نگارش یا استفاده از علائم نگارشی واضحتر میتواند دقت را افزایش دهد.

- در مجموعهدادههای فاینتیونینگ، تنوع زبانی و سبک را بالا ببرید و از نمونهسازی کنترلشده برای جلوگیری از سوگیریهای نامطلوب استفاده کنید.

- در پروژههای چندزبانه، از ارزیابیهای انسانی بومی برای مقایسهٔ خروجیها در هر زبان بهره ببرید، زیرا معیارهای خودکار ممکن است تفاوتهای معنایی ظریف را ثبت نکنند.

اداره ثبت اختراعات لهستان حتی در شبکههای اجتماعی اشاره کرد که نتایج نشان میدهد لهستانی دقیقترین زبان برای دستوردهی به هوش مصنوعی است و با طنزی افزود که شاید یادگیری لهستانی برای انسان دشوار باشد، اما این دشواری برای هوش مصنوعی صدق نمیکند.

ملاحظات مربوط به سیاستگذاری و تجاریسازی

برای شرکتها و دستگاههای دولتی که به دنبال راهکارهای هوش مصنوعی چندزبانه هستند، نتایج چنین مطالعاتی اهمیت زیادی دارد. تصمیمگیری دربارهٔ زبان مورد استفاده در رابطهای کاربری مبتنی بر هوش مصنوعی، اسناد راهنما و سیستمهای پشتیبانی مشتری میتواند بر اساس آزمایشهای محلی و زبانمحور اصلاح شود. این امر همچنین میتواند در انتخاب استراتژیهای ترجمه ماشینی، فاینتیون مدلها و تهیهٔ مجموعهدادههای محلیسازی به کار گرفته شود.

محدودیتها و احتیاطها

هرچند یافتهها جالباند، اما لازم است محدودیتهای مطالعه نیز مدنظر قرار گیرند. نتایج بسته به انتخاب مدلها، نسخهٔ مدلها، تنظیمات توکنسازی، کیفیت ترجمهها و معیارهای ارزیابی میتواند تغییر کند. علاوه بر این، ترکیب آموزشی هر مدل — از نظر متون خبری، محتوای وب، و متون علمی — نقش بزرگی در نحوهٔ پاسخگویی مدلها دارد.

بنابراین، نتیجهگیری کلی دربارهٔ «برتری یک زبان» باید محتاطانه انجام شود و بهعنوان سرآغاز یک خط تحقیقاتی گستردهتر در نظر گرفته شود تا حکم قطعی.

چه چیزی در ادامه خواهد آمد؟

پژوهشگران میگویند این پایان ماجرا نیست — کار بیشتری لازم است تا فهم بهتری از چگونگی تاثیر توکنسازی، توزیع دادههای آموزشی و ساختارهای زبانشناختی بر رفتار مدلها بهدست آید. با این وجود، این مطالعه جامعهٔ هوش مصنوعی را به بازنگری در فروض متداول وادار میکند و تاکید میکند که آزمایشها و بهینهسازیها باید در سطح چندزبانه انجام شوند.

مسیرهای تحقیقاتی آینده

مسیرهای تحقیقاتی که میتوانند از این مطالعه پدید آیند شامل مطالعات کنترلشده بر توکنسازی (مقایسهٔ BPE، WordPiece، unigram و روشهای مبتنی بر کاراکتر)، تحلیلهای دگرآزمایی (ablation) روی مجموعهدادههای آموزشی و بررسی اثرات فاینتیونینگ متمرکز بر یک زبان یا یک زیرمجموعهٔ دستوری خاص است. همچنین بررسی تعامل بین روشهای یادگیری تقویتی (مانند RLHF) و توانایی مدلها در پیروی از دستورالعملهای زبانی مختلف میتواند بینشهای عملیتری فراهم کند.

پیشنهادهایی برای پژوهشگران

پژوهشگران علاقهمند باید به طراحی آزمایشهایی بپردازند که متغیرهای کلیدی مانند اندازهٔ مدل، تنوع و کیفیت مجموعهدادههای پیشآموزشی، و زیرساخت توکنسازی را کنترل کنند. علاوه بر آن، استفاده از بنچمارکهای انسانی-محور و ابزارهای ارزیابی معناشناختی میتواند به درک دقیقتری از «کیفیت» خروجیها در سطوح مختلف کمک کند.

در مجموع، این یافتهها نشان میدهد که بهبود عملکرد مدلهای چندزبانه تنها از مسیر افزایش حجم داده نگذشته و توجه دقیق به ویژگیهای زبانی و طراحی پرامپت میتواند تاثیر قابلتوجهی داشته باشد.

نتیجهگیری

مطالعهٔ مشترک دانشگاه مریلند و مایکروسافت یادآور میشود که انتخاب زبان پرامپت میتواند بهطور قابلتوجهی بر کیفیت خروجی مدلهای زبانی بزرگ اثر بگذارد. برای مهندسان پرامپت، پژوهشگران و سازمانهایی که در زمینهٔ هوش مصنوعی چندزبانه فعالیت میکنند، این یافتهها انگیزهای برای آزمایشهای گستردهتر، طراحی بنچمارکهای متنوعتر و توجه بیشتر به ویژگیهای زبانی و توکنسازی فراهم میآورد. در نهایت، بهینهسازی پرامپت و ارزیابی مدلها در زبانهای محلی میتواند عملکرد کاربردهای عملی هوش مصنوعی را بهطور ملموسی بهبود بخشد.

منبع: smarti

ارسال نظر