8 دقیقه

OpenAI مدل جدیدی با نام GPT-5-Codex-Mini را معرفی کرده است؛ نسخهای جمعوجور و مقرونبهصرفه از مدل کدنویسی Codex مبتنی بر GPT-5 که هدف آن فراهم کردن دسترسی اقتصادیتر برای توسعهدهندگان به قابلیتهای پیشرفته تولید کد و پشتیبانی مهندسی نرمافزار است. این نسخه مینی برای تیمها و شرکتهایی طراحی شده که میخواهند اتوماسیون توسعه نرمافزار، تولید خودکار تستها، بازسازیهای گسترده کد و افزودن ویژگیها را با هزینه کمتر انجام دهند، بدون اینکه از همه مزایای مدل اصلی بهطور کامل صرفنظر کنند.

آنچه مدل جدید مینی ارائه میدهد

GPT-5-Codex-Mini نسخهای کوچکتر و بهینهشده از GPT-5-Codex است که بر کاهش هزینههای محاسباتی و افزایش نرخ بهرهبرداری تمرکز دارد. هدف این مدل حفظ بیشتر توانمندیهای کلیدی کدنویسی—مثل ایجاد پروژههای جدید، افزودن قابلیتها و تولید تستهای خودکار، بازآرایی و ریفکتورینگ در مقیاس بزرگ—در حین کاهش مصرف منابع محاسباتی است تا تیمها بتوانند تعداد زیادی وظیفه را با همان بودجه انجام دهند. به گفته OpenAI، در عمل Mini حدوداً چهار برابر استفادهپذیری بیشتری نسبت به نسخه کامل GPT-5-Codex فراهم میکند، البته با کاهش جزئی در دقت و قدرت استدلال. این توازن بین هزینه و کارایی میتواند برای بسیاری از گردشکارهای تولیدی جذاب باشد، بهخصوص جایی که حجم درخواستها بالا و حساسیت خطا میانرده یا پایین است.

عملکرد آن در عمل: ارقام بنچمارک واقعی

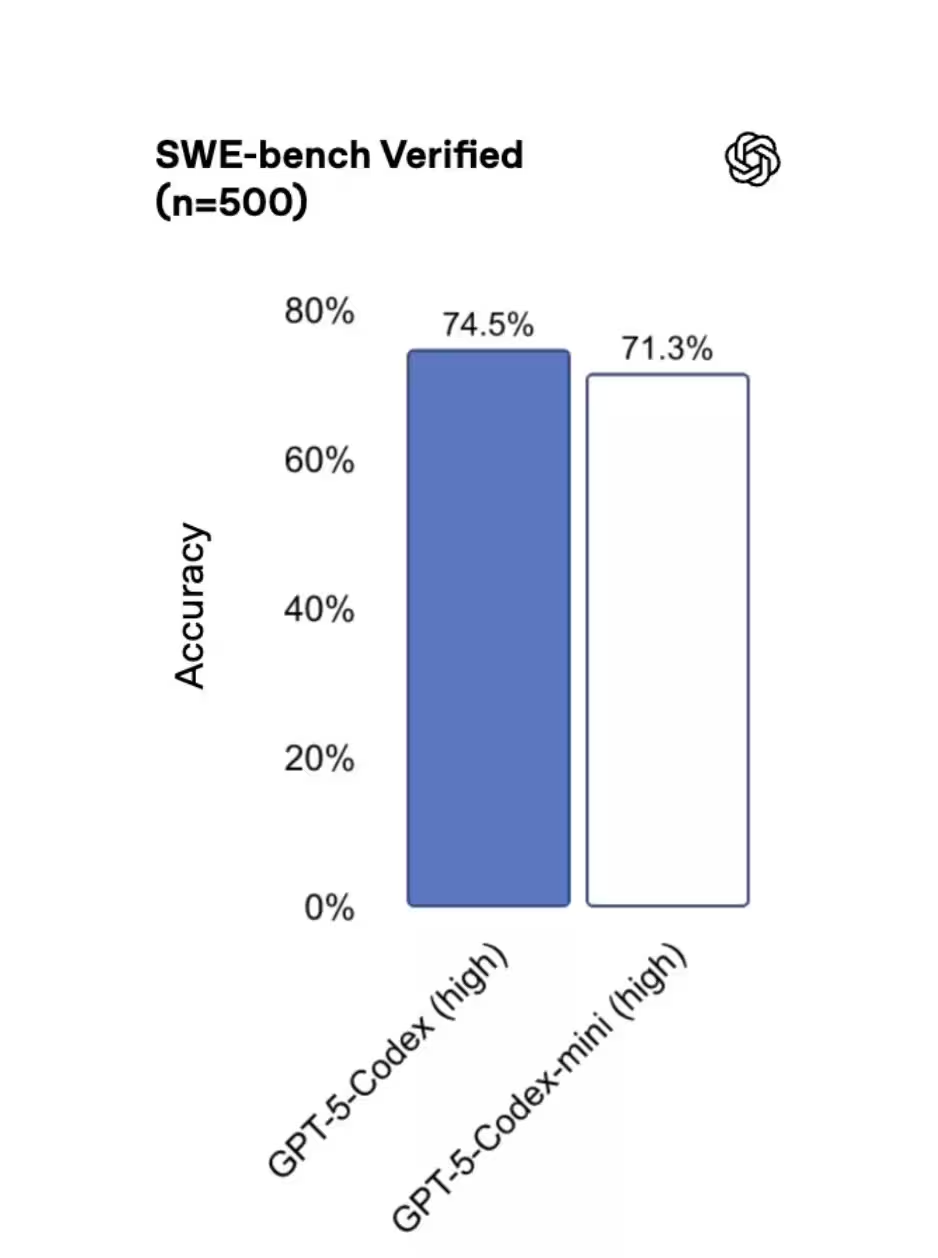

نتایج بنچمارکها روی مجموعه SWE-bench Verified نشان میدهد که سه مدل عملکرد نزدیکی به هم دارند: GPT-5 High با نمره 72.8%، GPT-5-Codex با 74.5% و GPT-5-Codex-Mini با 71.3% ثبت شدهاند. این ارقام نشان میدهد که مینی بخش زیادی از نقاط قوت مدل اصلی را حفظ کرده و در عین حال صرفهجویی معنیداری در هزینه ارائه میکند—یک معاوضه جذاب برای بسیاری از فرایندهای تولیدی. برای خواننده فنی، این به معنای آن است که برای وظایف استاندارد تولید کد، تولید تست واحد، خودکارسازی ریفکتورینگ ساختاری و تکمیل خودکار کد در ادیتور، میتوان روی مینی حساب باز کرد، در حالی که برای وظایف حساستر مثل طراحی الگوریتمهای بحرانی، تحلیل عمیق معماری یا کدنویسی امنیتی سطح بالا، نسخه کامل یا High همچنان برتری دارد.

برای تفسیر بهتر این بنچمارکها باید به چند نکته توجه کنید: اول اینکه امتیازهای درصدی نشاندهنده میانگین عملکرد در مجموعهای از تکالیف سنجشی است و دامنه خطا در هر تکلیف میتواند متفاوت باشد. دوم اینکه معیارهایی مانند «دقت» و «توانایی استدلال» معمولاً بسته به طول ورودی، زبان برنامهنویسی، و نوع وظیفه (مثلاً تولید کد جدید در مقابل تکمیل ساده) تغییر میکنند. سوم اینکه هزینه واقعیِ استفاده در محیط تولید وابسته است به حجم درخواستها، نرخ درخواست (rate limits) و زمانهای پاسخ (latency) که مدل ارائه میدهد.

چه زمانی توسعهدهندگان باید مینی را انتخاب کنند

چه زمانی مینی انتخاب درست است؟ OpenAI توصیه میکند از GPT-5-Codex-Mini برای کارهای مهندسی سبکتر یا بهعنوان گزینه پشتیبان زمانی که به محدودیتهای مصرف مدل اصلی نزدیک میشوید استفاده کنید. ابزارهای Codex حتی پیشنهاد میکنند پس از رسیدن به حدود 90% سهمیه، سوییچ به مینی انجام شود. میتوانید مینی را مانند یک دریچه گاز در نظر بگیرید: کارهای با ریسک بالا و حساس را روی مدل کامل نگه دارید و وظایف تکراری یا با حجم بالا را به مینی منتقل کنید تا بودجه و توان عملیاتی افزایش یابد.

نمونههایی از موارد مناسب برای مینی عبارتاند از: تولید اولیه کد برای ماژولهای غیر بحرانی، تولید و اصلاح تستهای واحد و یکپارچه، اصلاحات سبک و خودکارسازی فرایندهای CI/CD، تولید مستندات کد و مثالهای استفاده، رفع خطاهای رایج یا بازآراییهای ساختاری که نیاز به استدلال سطح بالا ندارند. همچنین میتوان از مینی برای پردازش دستهای تراکنشهای کمریسک، بررسیهای اولیه pull requestها، و اجرای اسکریپتهای تولیدی در محیطهای محلی یا سرورها استفاده کرد.

در مقابل، برای مواردی مانند بازنگری امنیتی کد، طراحی الگوریتمهای کارآمد و هدفمند، نوشتن کتابخانههای پایه با نیاز به برآوردهای دقیق و قابل اثبات یا بازنویسیهای حساس معماری، مدل کامل GPT-5-Codex یا GPT-5 High همچنان گزینه بهتری است. بنابراین استراتژی ترکیبی—نگهداری کارهای حساس روی مدل کامل و انتقال حجم بالای کارهای تکراری یا کمریسک به مینی—معمولاً بهترین نتیجه را از منظر هزینه و کیفیت فراهم میآورد.

هماکنون کجا میتوانید از آن استفاده کنید

مینی هماکنون در رابط خط فرمان (CLI) و بهصورت افزونه برای IDE در دسترس است و پشتیبانی API نیز بهزودی اضافه خواهد شد. این یعنی توسعهدهندگان میتوانند همین الآن آن را در جریانهای کاری محلی، خطوط CI، و جلسات کدنویسی هدایتشده توسط ادیتور ادغام کنند—پیش از آنکه عرضه کامل API انجام شود. دسترسی از طریق CLI به تیمها امکان میدهد مینی را در اسکریپتهای اتوماسیون، کارهای زمانبندیشده و ابزارهای توسعه محلی نصب و اجرا کنند، و افزونه IDE تجربه تعاملی تکمیل کد، پیشنهادهای فوری و تولید تست را داخل محیط توسعه فراهم میکند.

در عمل، ادغام مینی میتواند شامل موارد زیر باشد: فراخوانی مدل برای تکمیل کد در زمان نوشتن با استفاده از افزونه ادیتور؛ استفاده در مراحل پیشساخت (pre-build) برای تولید تستهای اسکلت؛ اجرای روتینهای بازآرایی کد در pipelineهای CI برای حفظ کیفیت کد در مخازن بزرگ؛ و بهکارگیری در اسکریپتهای خودکارسازی که وظایف تکراری مانند فرمتینگ، lint fixing و تولید مستندات را مدیریت میکنند. وقتی API عمومی راهاندازی شد، ادغامهای بیشتر با سرویسهای ابری و ابزارهای مدیریت چرخه حیات نرمافزار (ALM) و سیستمهای بررسی کد (code review) نیز سادهتر خواهد شد.

پشت صحنه: بهبودهای عملکرد و قابلیت اطمینان

OpenAI همچنین بهبودهایی در زیرساخت اعلام کرد تا استفاده از Codex قابل پیشبینیتر شود. بهینهسازیهای مرتبط با کارایی GPU و مسیردهی (routing) باعث شده OpenAI بتواند محدودیتهای نرخ درخواست را برای مشترکان ChatGPT Plus، Business و Education تا 50% افزایش دهد. مشتریان Pro و Enterprise پردازش اولویتدار دریافت میکنند تا سرعت و پاسخدهی در پیکهای ترافیک حفظ شود. پیشتر مشکلاتی ناشی از خطاهای کشینگ وجود داشت که ظرفیت قابلاستفاده را کاهش میداد؛ این مشکلات مرتفع شدهاند و در نتیجه توسعهدهندگان باید در طول روز تجربهای پایدارتر و قابلاطمینانتر مشاهده کنند.

از جنبه فنی، بهبودهای صورتگرفته میتوانند شامل مواردی مثل: بهینهسازی تخصیص حافظه GPU برای بارهای کاری کوتاهمدت و طولانیمدت، استفاده بهتر از قدرت محاسباتی با خوشهبندی درخواستها، پیادهسازی سیاستهای پیشرفته cache invalidation برای جلوگیری از ناکارآمدی، و مکانیزمهای routing که بر اساس معیارهایی چون latency و بار کار مرکز داده تصمیم میگیرند درخواست را به کدام نمونه از مدل ارسال کنند. این تغییرات معمولاً به کاهش میانگین زمان پاسخ، افزایش تحمل بار (throughput) و ثبات در پیکهای مصرف منجر میشوند که برای محیطهای production بسیار مهم است.

افزون بر این، افزایشی که در نرخ درخواست اعمال شده به تیمها اجازه میدهد آزمایشهای بیشتری انجام دهند، پخش ترافیک را به شکل انعطافپذیرتری مدیریت کنند و تجربه کاربری بهتری در ابزارهای تعاملی دریافت کنند. برای مشتریان سازمانی، اولویتبندی پردازش میتواند به معنی کاهش زمان انتظار در صف و تضمین سطح سرویس (SLA) بهتر در ساعات اوج باشد. همه این بهبودها در کنار عرضه نسخه مینی، به تیمها کمک میکند تا با هزینه کمتر، حجم بیشتری از وظایف مهندسی را خودکار کنند و در عین حال از پایداری و عملکرد قابل قبول برخوردار باشند.

جمعبندی: GPT-5-Codex-Mini راهی عملی برای مقیاسبخشی اتوماسیون کدنویسی ارائه میدهد بدون اینکه هزینهها بهصورت متناسب افزایش یابند. برای بسیاری از توسعهدهندگان، این نسخه انتخاب هوشمندانهای برای کارهای حجیم یا کمخطر خواهد بود—بهویژه در حالی که OpenAI دسترسی API را گسترش داده و تضمینهای عملکردی را تقویت میکند. در نهایت، انتخاب میان نسخهها باید بر اساس نیازهای کیفیت، حساسیت وظایف، و محدودیتهای بودجه انجام شود؛ استفاده ترکیبی از مدلها و سیاستهای هوشمندانه نرخدهی معمولاً بیشترین ارزش را به همراه دارد.

منبع: smarti

ارسال نظر