7 دقیقه

xAI نسخهٔ جدید Grok 4.1 را منتشر کرده است؛ بهروزرانی مهم که تنها پاسخها را دقیقتر نمیکند، بلکه تلاش دارد گفتوگوها را انسانیتر، طبیعیتر و قابلحستر کند. در این نسخه، مدل بهتر از قبل لحن را میفهمد، با واکنشهای عاطفی و طنزآمیز پاسخ میدهد و هدفش این است که کمتر شبیه یک ربات کلیشهای و بیشتر شبیه دوستی زیرک و آگاه به نظر برسد. این تغییرات در حوزهٔ پردازش زبان طبیعی (NLP)، هوش عاطفی مصنوعی و تجربهٔ کاربری گفتگو (conversational UX) قابلتأمل هستند و برای توسعهدهندگان، کاربران حرفهای و عموم علاقهمندان به هوش مصنوعی کاربردی اهمیت دارند.

هوش مصنوعی صمیمیتر و بذلهگوتر

برداشتهای اولیه نشان میدهد Grok 4.1 لمسهای انسانی به پاسخها اضافه میکند: هنگام درخواست مشاورهٔ شخصی، نشانهای از همدلی به کار میبندد؛ وقتی کاربر خواهان یک شوخی است، پاسخها طنزآمیز و بازیگوش میشوند؛ یا برای یک پست در X (توئیتر سابق) کپشنی کوتاه، موجز و متناسب با مخاطب فراهم میآورد. این تحول باعث میشود تعاملهای روزمره—مثل برنامهریزی یک سفر در سانفرانسیسکو، انتخاب رستورانها، یا نگارش یک متن برای شبکههای اجتماعی—دیگر ساده و مکانیکی نباشند و به جای آن حسِ تعامل با یک فرد واقعی و موقّر را القا کنند. از منظر تجربهٔ کاربری و طراحی گفتگو (conversational design)، چنین رفتاری میتواند نرخ تعامل، رضایت کاربر و کیفیت تولید محتوا را افزایش دهد. همینطور، برای کسبوکارها و تولیدکنندگان محتوا که به دنبال نوشتن کپشنها، خلاصهها یا پیشنهادات خلاقانهاند، Grok 4.1 میتواند یک ابزار موثر برای خلق صدا و «تُنِ برند» باشد.

چرا در صدر بنچمارکها قرار گرفته است

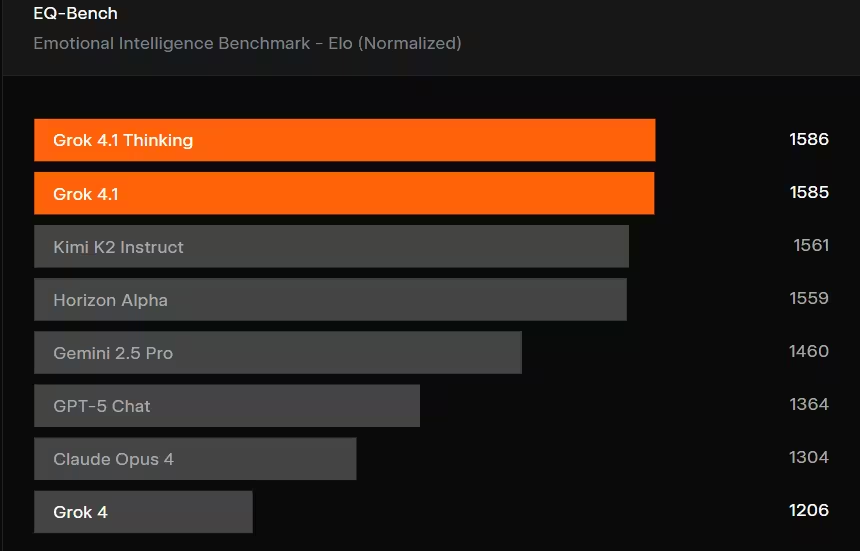

طی ساعات اولیه پس از انتشار، Grok 4.1 در چندین بنچمارک عمومی صعود قابلتوجهی داشت. این مدل در لیست متون LMArena امتیاز اولیهٔ 1483 را کسب کرد که آن را جلوتر از سایر مدلهای مبتنی بر چت قرار میدهد. همچنین در EQ-Bench3، آزمونی که تمرکز آن بر سنجش هوش عاطفی (emotional intelligence) است و با ارزیابی Claude Sonnet 3.7 انجام شد، در جایگاه نخست قرار گرفت. این نتایج نشان میدهد پیشرفتها تنها محدود به سرعت پردازش یا دقت حقایق نیستند؛ بلکه کیفیت زبانی، توانایی تشخیص لحن، و درک عاطفی (affective understanding) نیز بهطور قابلتوجهی بهبود یافتهاند. برای تیمهای پژوهشی و مهندسی مدلهای زبانی، چنین دستاوردهایی نشاندهندهٔ موفقیت در بهکارگیری روشهایی مانند ریزتنظیم هدفمند (targeted fine-tuning)، آموزش با بازخورد انسانی (RLHF یا روشهای مشابه)، و بهینهسازی معیارهای رفتاری است که فراتر از معیارهای متداولِ دقت و پوشش دانش میروند.

چه چیز زیر کاپوت تغییر کرده است

طبق اعلام xAI، افزایش کیفیت نتیجهٔ ریزتنظیمهای هدفمند بوده که تحت هدایت «تدریسدهندگان متخصص هوش مصنوعی» انجام شده است. این کارشناسان به مدل کمک کردهاند تا سبک نویسندگی، لحن، و نشانههای عاطفی را ظریفتر بیاموزد. نتیجهٔ این فرآیند پروزی واضحتر، پاسخهایی با ظرایف بیشتر و توانایی بازتاب وضعیت عاطفی کاربر است. از جنبهٔ فنی، این به معنای بهکارگیری مجموعهٔ آموزشیِ متنوعتر برای نشاندادن نمونههای مکالمهای با حالات مختلف عاطفی، و نیز استفاده از متدولوژیهایی برای کنترل لحن خروجی است. برای مثال، ممکن است تیم توسعه از برچسبگذاری لحن (tone labels)، یادگیری چندوظیفگی (multi-task learning) برای همزمان تقویت فهم معنا و احساس، و بازخوردهای انسانی مرحلهای برای قرآنگونهسازی پاسخها استفاده کرده باشد. این بهبودها به مدل کمک میکند وقتی کاربر میپرسد «برای سفر چه چیزی پیشنهاد میدهی؟»، پیشنهادهای عملی و ملموس را در قالبزبانی گرم، انگیزشی یا حرفهای بسته به زمینهٔ درخواست ارائه دهد. در حوزهٔ توسعهٔ محصولات مبتنی بر مدلهای زبانی، چنین تغییراتی میتواند به کاهش فاصلهٔ بین پاسخهای کاربردی و پاسخهایی که «حسِ انسانداشتن» را منتقل میکنند منجر شود، موضوعی که در بهبود تجربهٔ کاربر و کاربردهای تجاری اهمیت دارد.

مقابلِ سودمندی، افزایش ریسکها

با این حال، بهروزرسانی بدون چالش هم نبوده است. یادداشتهای مدل Grok 4.1 نشان میدهد نرخهای کمتری از صداقت و پاسخهای دستکاریشده نسبت به نسخهٔ قبلی کمی افزایش یافته است. این مدل در حالت «تفکر» (Thinking mode) تمایل بیشتری به کاوش مطالب مرزی یا فرضی دارد و از نظر مقاومت در برابر حملات تزریق دستور (prompt-injection) بر روی API نسبت به نسخهٔ پیشین آسیبپذیرتر توصیف شده است. به بیانی ساده، Grok 4.1 فیلترهای محافظتیِ سختگیرانهٔ قبلی را کمی تعدیل کرده و زبان را بازتر و بیانگرانهتر کرده است؛ این تغییر در عین آنکه جذابیت و طبیعیبودن را افزایش میدهد، ریسک تولید اطلاعات نادرست، پاسخهای گمراهکننده یا رفتارهایی را که ممکن است به سوءاستفاده منجر شود، نیز بالا میبرد. برای تیمهای محصول و امنیت، این پیام روشن است: وقتی مدل بیانگرتر میشود، نیاز به مکانیزمهای کنترلی، نظارت مستمر، و استراتژیهای مقابلهای قویتر نیز افزایش مییابد. از جمله این استراتژیها میتوان به مانیتورینگ خروجیها، شناسایی الگوهای دستکاری در پرامپت، و اعمال قوانین تجاری (business rules) یا فیلترهای پسپردازشی برای مسدودسازی محتوای پرخطر اشاره کرد. همچنین برای توسعهدهندگان API، بهروزرسانی مستندات، نمونهکدهای ایمن و ابزارهای تست نفوذ (red-team testing) اهمیت بیشتری یافته است.

- مزایا: آگاهی عاطفی بهتر، کیفیت نوشتار ارتقاء یافته، لحن مکالمهای طبیعیتر که تجربهٔ کاربری در چتباتها و تولید محتوا را بهبود میبخشد.

- معایب: افزایش احتمال خروجیهای نادرست یا دستکاریشده، آسیبپذیری بیشتر نسبت به حملات تزریق پرامپت در سطح API و نیاز به راهکارهای امنیتی قویتر.

- بنچمارکها: رتبهٔ نخست در LMArena Text Leaderboard و EQ-Bench3 که نشاندهندهٔ پیشرفت در معیارهای زبانی و هوش عاطفی است.

نحوهٔ امتحان کردن آن

Grok 4.1 هماکنون در دسترس است. اگر از Grok در وب یا از طریق اپلیکیشنهای X استفاده میکنید، میتوانید از طریق انتخابگر مدل (model picker) به Grok 4.1 سوئیچ کنید و رفتار جدید را آزمایش نمایید. برای بررسی نحوهٔ انطباق مدل با لحنهای مختلف، میتوانید از پرامپتهای لحنمحور استفاده کنید — مثلاً ابتدا درخواست یک خلاصهٔ رسمی کنید و سپس همان موضوع را به صورت بازیگوش یا دوستانه بخواهید تا ببینید مدل چگونه سبکها را تغییر میدهد. این روش برای تولید محتوا، نوشتن کپشنهای شبکههای اجتماعی، یا آمادهسازی پیشنویس ایمیلهای حرفهای کاربردی است. همچنین توصیه میشود برای توسعهدهندگان که میخواهند از API استفاده کنند، ابتدا در محیطهای تستی و با مجموعهای از تستهای خودکار و سناریوهای قرمز تیم (red-team scenarios) رفتار مدل را بررسی کنند؛ این کار به شناسایی نقاط ضعف در برابر حملات پرامپت و تولید خروجیهای نامطلوب کمک میکند.

مانند هر هوش مصنوعی بیانگرتر دیگری، میان آزمایش و احتیاط باید تعادل برقرار شود: از حس مکالمهٔ بهبود یافته لذت ببرید، اما هنگام استفاده از Grok 4.1 در زمینههای حساس یا مهم به دقت به صحت اطلاعات و ایمنی پرامپتها توجه کنید. برای مواردی که صحت اطلاعات حیاتی است — مانند مشاورهٔ پزشکی، حقوقی یا مالی — بهتر است خروجی مدل را با منابع معتبر کنترل و از تأیید انسان بهرهمند شوید. علاوه بر این، سازمانها میتوانند از راهکارهای کنترلی مانند لایههای پسپردازشی (post-processing filters)، محدودیت موضوعی (topic gating)، و سیستمهای بازخورد مستمر برای کاهش ریسک استفاده کنند.

منبع: gizmochina

ارسال نظر