9 دقیقه

مقدمه

تیم پژوهشی اپل پرسشی ساده اما نگرانکننده مطرح کرد: مردم واقعی از عاملهای هوش مصنوعی که در انجام کارهای روزمره کمک میکنند، دقیقاً چه انتظاراتی دارند؟ پاسخ خوشقواره و تمیز نیست. این پاسخ آشفته، انسانی و پر از مصالحهها و انتخابهای طراحی است. در این مقاله به بررسی نتایج مطالعهای پرداخته میشود که تلاش میکند تجربه کاربری (UX) هنگام تعامل با عاملهای استفاده از رایانه را روشمند کند و چارچوبی عملی برای طراحی ارائه دهد.

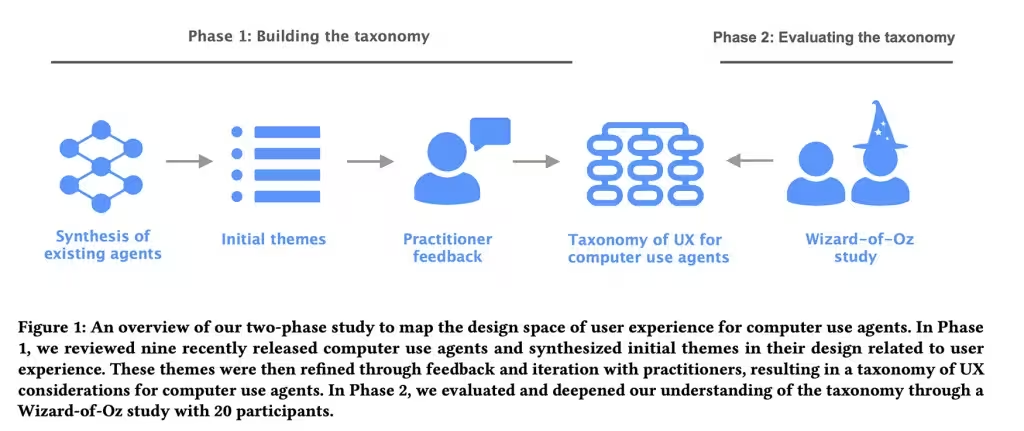

روششناسی مطالعه

مقالهای تحت عنوان نقشهبرداری فضای طراحی تجربه کاربری برای عاملهای استفاده از رایانه (Mapping the Design Space of User Experience for Computer Use Agents) به بررسی نه عامل موجود پرداخته است؛ نامهایی مانند Claude Computer Use Tool، Adept، OpenAI Operator، AIlice، Magentic-UI، UI-TARS، Project Mariner، TaxyAI و AutoGLM. هدفِ پژوهشگران، ترسیمِ نحوه نمایش قابلیتها، مدیریت خطاها و دعوت به کنترل کاربر توسط این سیستمها بود.

فاز نخست: مشاهده و دستهبندی

در فاز اول، هشت متخصص UX و هوش مصنوعی بهصورت مشاهدهای و طبقهبندیگرایانه صحنه را تحلیل کردند. آنها چشمانداز را به چهار دستهٔ اصلی، ۲۱ زیررده و ۵۵ ویژگی طراحی مشخص و قابل اندازهگیری تقسیمبندی کردند. این ویژگیها از نحوهٔ ورود اطلاعات توسط کاربر به عامل، تا میزان شفافیت اقدامات عامل، تا میزان کنترلی که کاربر حفظ میکند و نحوهٔ شکلگیری مدلهای ذهنی و انتظارات متغیر بودند.

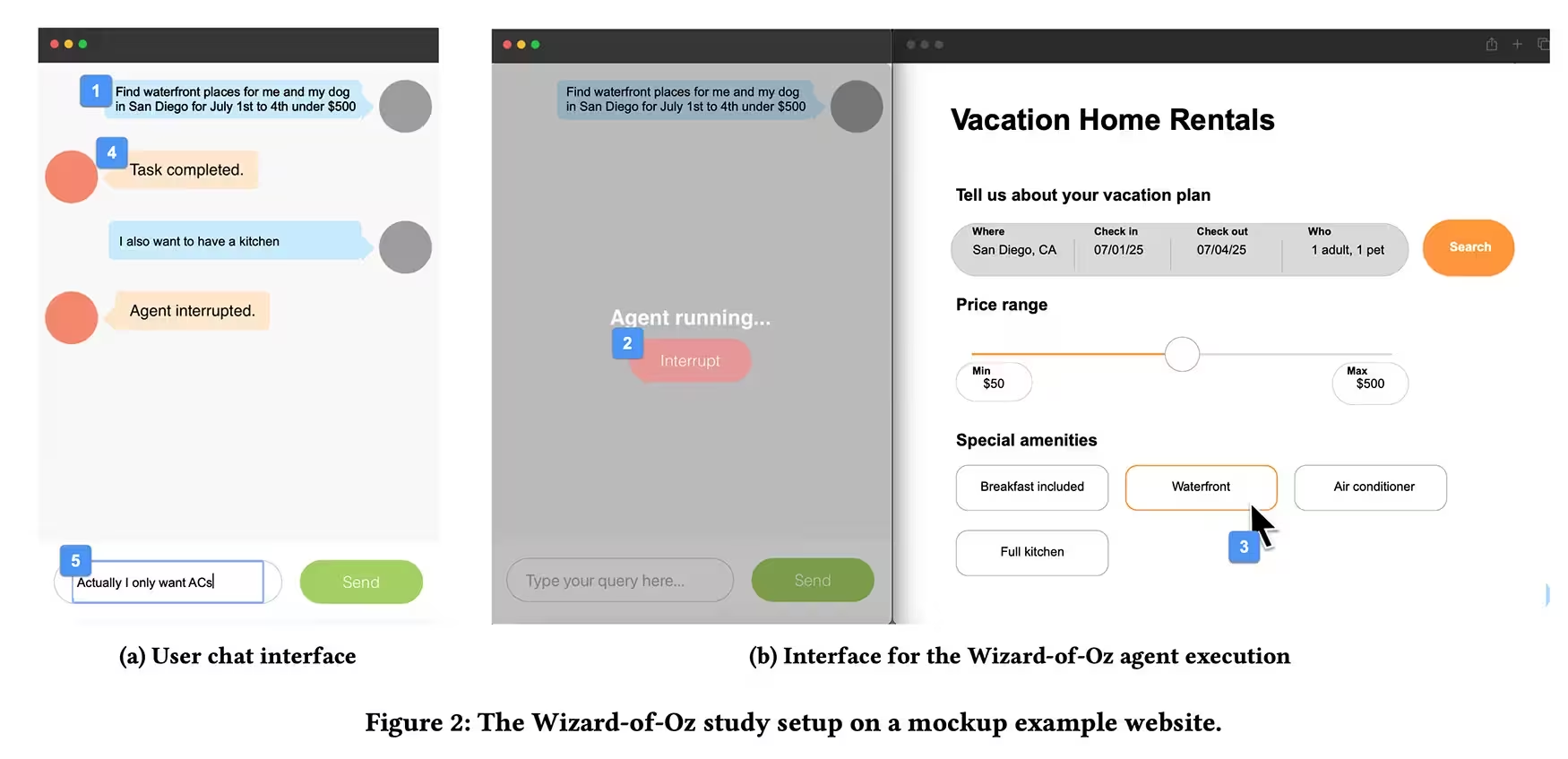

فاز دوم: آزمایش «جادوگر شهر اُز» (Wizard of Oz)

در مرحلهٔ بعد تیم آزمایشی از روش کلاسیک «جادوگر شهر اُز» استفاده کرد. بیست شرکتکننده که تجربهٔ قبلی کار با دستیارهای هوش مصنوعی داشتند، از طریق یک رابط گفتگو (chat-style) وظایفی مانند رزرو تعطیلات یا خرید آنلاین را به عاملها واگذار کردند در حالی که یک پژوهشگر، خارج از دید، در نقش عامل با کیبورد و ماوس کنترل عملیات را بهدست داشت. شرکتکنندگان میتوانستند دستورات را تایپ کنند و با فشردن دکمهٔ توقف عملیات عامل را متوقف کنند. بعضی از وظایف عمداً با خطا یا وقفهٔ غیرمنتظره خراب شدند تا واکنش افراد هنگام اشتباه یا فرضیات نادرست عامل مشاهده شود.

یافتههای کلیدی

یک الگوی روشن از تعاملاتِ انسانی و فناوری پدیدار شد: کاربران میخواهند بدانند عامل چه میکند، اما نمیخواهند هر کلیک را ریزمدیریت کنند. نمایشهای کوتاه و تأییدهای مقطعی آرامشبخش هستند. سکوت کامل از طرف عامل موجب بیاعتمادی میشود و خودکارسازی ناگهانی بدون توضیح نیز همین اثر را دارد.

نیازهای نوآموزان و متخصصان

نوآموزان (کاربرانی که آشنایی کمی با سیستم دارند) تفسیرهای گامبهگام و نقاط بازرسی نرم میخواهند، مخصوصاً زمانی که عملیات پیامدهای ملموس دارد — مثلاً خرید، تغییر در حساب، یا هر کاری که بهسادگی قابل بازگشت نیست. در مقابل، متخصصان ترجیح میدهند عامل مانند یک همکار مورد اعتماد عمل کند تا یک دستیار محتاط؛ آنها توانایی خود در کنترل را به عامل بیشتری میسپارند تا سرعت و کارایی افزایش یابد.

اعتماد مثل شیشه است

مطالعه نشان میدهد اعتماد رفتار شکننده و سریعی دارد: فروپاشی آن آسانتر از ساخته شدنش است. فرضیات پنهان یا خطاهای کوچک، اعتماد را سریعتر فرسایش میدهند تا عملکرد روان باعث افزایش سریع اعتماد شود. وقتی عامل از سناریوی پیشبینیشده خارج میشود یا با ابهام مواجه میشود، شرکتکنندگان ترجیح میدهند عامل مکث کند و سؤال بپرسد تا اینکه حدس بزند و عمل کند. این ترجیح حتی زمانی که تأییدهای اضافی کمی آزاردهنده بهنظر میرسند نیز پابرجا بود — کاربران ظاهراً میگفتند «بهتر است محتاطانه عمل شود تا پشیمان شویم». (کلیدواژههای مرتبط: اعتماد به هوش مصنوعی، مدیریت خطا، شفافیت در عاملهای هوش مصنوعی)

چارچوب طراحی و ویژگیهای قابل آزمایش

پژوهشگران چارچوبی کاربردی عرضه کردند — نه صرفاً دیوارکوب نظری — که چهار دستهٔ اصلی و دهها ویژگی قابل آزمون را معرفی میکند. این چارچوب به تیمهای محصول، طراحان تجربهٔ کاربری و مهندسان یاد میدهد چگونه تصمیمهای طراحی را مبتنی بر رفتار واقعی کاربران سنجش و تکرار کنند.

چهار دستهٔ اصلی

- ورودی و کنترل کاربر: چگونگی وارد کردن دستورها، امکان بازگرداندن و توقف عملیات، و قابلیتهای اصلاح و ویرایش.

- شفافیت و نمایش قصد: نشان دادن گامهای در حال انجام، دلایل پیشنهادات عامل، و پیشرفت عملیات.

- پاسخ به خطا و بازیابی: استراتژیهای نمایش خطا، پیشنهاد راهحلهای جایگزین و نحوهٔ پرسش از کاربر در شرایط مبهم.

- مدلهای ذهنی و انتظارات: نحوهٔ شکلگیری تصویر کاربر از تواناییها و محدودیتهای عامل و مدیریت توقعات کاربری.

نمونهٔ ویژگیهای مشخص

ویژگیها شامل نمایش پیشنمایش اقدامات پیشبینیشده، بازخوردِ زمانبندیشده (مثلاً نوار پیشرفت)، تأییدهای ترتیبی برای تراکنشهای حساس، امکان ورود دستی برای اصلاح، و پیامهای خطای قابل فهم بهجای کدهای فنی بودند. این فهرست ۵۵عنصر به طراحان اجازه میدهد تا اجزا را جداگانه آزمون کنند: کدام تأییدها در چه سطوحی از ریسک لازم است، کجا میتوان تصمیم را به عامل واگذار کرد و چگونه باید رفتار عامل را تنظیم کرد تا با سابقه و مهارت کاربر هماهنگ شود.

راهنماییهای عملی برای طراحان و تولیدکنندگان اپلیکیشن

پیام عملی پژوهش روشن است: عاملهای هوش مصنوعی را طوری طراحی کنید که سطح شفافیت و کنترل را با توجه به نوع کار و تجربهٔ کاربر سازگار کنند. در ادامه چند توصیهٔ کاربردی و مؤثر آورده شده است که میتوان بلافاصله در فرآیند طراحی و توسعه بهکار برد (کلیدواژهها: طراحی رابط کاربری عامل هوش مصنوعی، شفافیت عملکرد، کنترل کاربر):

قابلیتهایی که باید پیاده شوند

- نمایش قصد: همیشه قصد عامل را بهصورت خلاصه نشان دهید (چه میخواهد انجام دهد و چرا).

- نوارهای پیشرفت و مرحلهای: برای عملیات چندمرحلهای، گامها را آشکار کنید تا کاربر حسِ پیگیری و کنترل داشته باشد.

- تأییدهای هوشمند: برای عملیات برگشتناپذیر مانند پرداخت یا تغییرات حساب، تأییدهای چندمرحلهای اضافه کنید.

- امکان توقف و بازگشت: دکمهٔ توقف واضح و گزینهٔ بازگردانی سریع را فراهم کنید تا کاربران در صورت نگرانی، عملیات را قطع کنند.

- پرسش هنگام ابهام: در مواجهه با اطلاعات ناقص یا تناقض، عامل باید مکث کند و سؤال بپرسد بهجای حدس زدن و اقدام خودسرانه.

تنظیم رفتار بر اساس مهارت کاربر

سطح توضیح و کنترل را بر اساس پروفایل کاربر یا رفتار گذشته او تنظیم کنید: برای نوآموزان توضیحات گامبهگام و نقاط کنترل بیشتر فراهم کنید؛ برای کاربران حرفهای گزینههایی برای «حالت سریع» یا «اختیارات پیشرفته» ارائه دهید که تأییدها را کاهش میدهد و اجازه میدهد عامل با کمترین اصطکاک عمل کند.

متریکها و آزمایش

معیارهای موفقیت باید فراتر از دقت مدل باشد و شامل معیارهای تجربهٔ کاربری شوند: نرخ تکمیل موفقیتآمیز وظایف، فراوانی قطع عملیات توسط کاربر، میزان بازگشت به حالت قبل، امتیاز اعتماد کاربر (surveys) و تحلیل وقایع زمانی (مثلاً جایی که کاربران قطع میکنند). این دادهها به تیمها کمک میکنند تا تعادل مناسب بین اتوماسیون و کنترل کاربر را پیدا کنند.

تفکر فنی و نکات اجرایی

طراحی عاملهای هوش مصنوعی فقط به مدلهای هوشمند مربوط نیست، بلکه به تعاملات هوشمندانه مربوط است. از منظر فنی این به معنی یکپارچهسازی چند لایه است:

- لایهٔ ارائهٔ قصد و شفافیت: پیادهسازی APIهایی که وضعیت داخلی عامل را بهصورت امن برای نمایش در رابط کاربری ارسال کند، بدون آنکه امنیت یا دادههای حساس را به خطر بیندازد.

- لایهٔ کنترل و بازخوانی دستورها: ثبت دقیق اقدامات پیشنهادی عامل (action logs) و فراهم کردن نقطهٔ بازگشت یا undo برای عملیات مهم.

- لایهٔ ارزیابی ریسک/اهمیت: موتورهای تصمیمگیری سبک که قبل از اجرای هر عملیاتی درجهٔ حساسیت یا ریسک را ارزیابی کنند و بر مبنای آن نیاز به تأیید کاربر را مشخص کنند.

- لایهٔ یادگیری از تعاملات: جمعآوری و تحلیل بازخوردهای کاربر برای تطبیق خودکار سطح توضیح و کنترل در تعاملات آینده.

پیامدها و نتیجهگیری

مسئله تنها داشتن مدلهای هوشمندتر نیست؛ مسئله طراحی تعاملات هوشمندتر است. در کوتاهمدت، انتخابهای کوچک — یک تأیید در اینجا، یک گام نمایان در آنجا، یک مکث محدود زمانی هنگامی که عامل دودل میشود — تعیین میکنند که آیا مردم به اتوماسیون اعتماد میکنند یا آن را خاموش میکنند. برای سازندگان محصول، طراحان تجربهٔ کاربری و مهندسان سیستم، این پژوهش چارچوبی کاربردی فراهم میآورد تا تصمیمها را بر مبنای رفتار واقعی کاربران بسنجند و تکرار کنند.

چکلیست سریع برای اجرا

- آیا قصدِ عامل بهصورت واضح نمایش داده میشود؟

- آیا عملیات حساس نیاز به تأیید اضافی دارد؟

- آیا کاربر میتواند عملیات را بهسادگی متوقف یا اصلاح کند؟

- آیا در شرایط ابهام، عامل سؤال میپرسد؟

- آیا سطوح توضیح براساس تجربهٔ کاربر تنظیم میشود؟

در مجموع، طراحی عاملهای هوش مصنوعی که میخواهند در کارهای روزمره مردم نقش موثری بازی کنند، مستلزم ترکیبی از شفافیت، کنترل انعطافپذیر و حساسیت به بافت تجربی کاربر است. این عناصر نه تنها رضایت و کارایی را افزایش میدهند، بلکه کلید ساختن اعتماد پایدار به اتوماسیونهای هوشمند هستند.

منبع: smarti

ارسال نظر